Tuy các mô hình ngôn ngữ lớn (LLMs) mang lại nhiều bước tiến quan trọng cho trí tuệ nhân tạo nhưng vẫn tồn tại những hạn chế nhất định. Trong một số trường hợp, mô hình có thể tạo ra thông tin sai lệch hoặc thiếu cơ sở nhưng vẫn trình bày với mức độ tự tin cao, hiện tượng này được gọi là ảo giác AI (Hallucination). Trong phạm vi bài viết này, FPT.AI sẽ giải thích chi tiết khái niệm, phân tích nguyên nhân cốt lõi và đề xuất những giải pháp nhằm giảm thiểu vấn đề ảo giác AI.

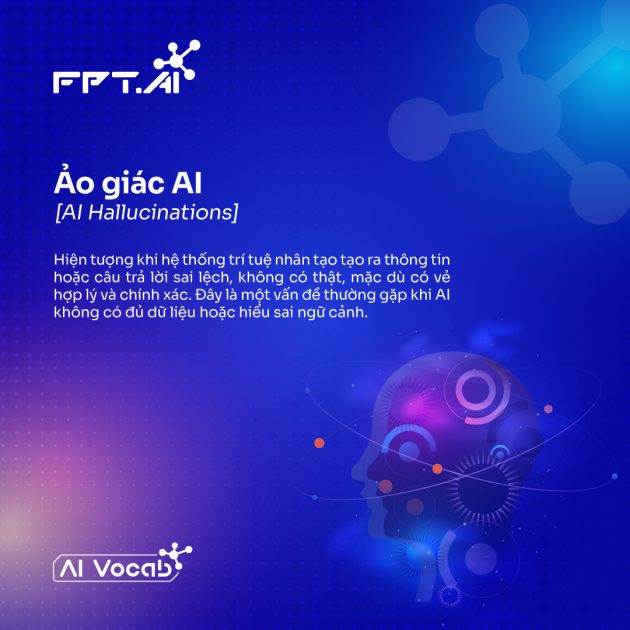

Hiện tượng ảo giác AI là gì?

Ảo giác AI hay Hallucination là hiện tượng trong đó các mô hình trí tuệ nhân tạo, đặc biệt là mô hình ngôn ngữ lớn (LLMs), tạo ra nội dung sai lệch, không liên quan hoặc hoàn toàn bịa đặt nhưng vẫn trình bày một cách trôi chảy và thuyết phục. Bản thân mô hình không có khả năng nhận biết tính đúng sai của thông tin, chỉ dự đoán và tái tạo mẫu dữ liệu đã học. Vì thế, đôi khi sẽ sinh ra kết quả vượt xa thực tế.

Khác với lỗi lập trình truyền thống có thể xác định và khắc phục trực tiếp, ảo giác AI xuất phát từ cơ chế vận hành của mô hình. Đây không phải là lỗi kỹ thuật đơn lẻ, mà là hệ quả tự nhiên của quá trình học và sinh nội dung của hệ thống.

Ví dụ về hiện tượng ảo giác AI

Dưới đây là một số tình huống nổi bật cho thấy ảo giác AI có thể xuất hiện trong nhiều ngữ cảnh khác nhau. Những ví dụ này minh họa cách mô hình ngôn ngữ lớn tạo ra thông tin nghe có vẻ hợp lý, nhưng thực tế lại sai lệch hoặc không tồn tại.

Trả lời câu hỏi kiến thức: Khi trả lời các câu hỏi về nhân vật hoặc sự kiện, mô hình có thể tạo ra thông tin tiểu sử không chính xác. Chẳng hạn, AI có thể khẳng định một diễn viên từng đoạt giải Oscar dù trên thực tế người đó chưa từng được đề cử. Sai lệch này thường xuất hiện khi mô hình suy đoán dựa trên các mẫu dữ liệu tương tự thay vì dựa trên thông tin đã được kiểm chứng.

Tạo nội dung văn bản: Trong quá trình viết bài về các chủ đề lịch sử hoặc học thuật, AI có thể tự thêm vào những chi tiết không có thật. Ví dụ, khi viết về Chiến tranh Thế giới II, mô hình có thể mô tả một trận đánh chưa từng xảy ra hoặc đưa ra số liệu thương vong sai lệch. Những chi tiết này khiến nội dung trông đầy đủ và thuyết phục, nhưng lại làm giảm độ tin cậy của thông tin.

Hỗ trợ lập trình: Khi giải thích thư viện hoặc sinh mã nguồn, mô hình đôi khi tạo ra các hàm hoặc phương thức không tồn tại. Ví dụ, AI có thể mô tả một phương thức trong một thư viện Python phổ biến dù trên thực tế thư viện đó không hề cung cấp chức năng như vậy. Điều này có thể gây nhầm lẫn và làm chậm quá trình phát triển phần mềm nếu người dùng không kiểm tra lại tài liệu chính thức.

Ảo giác AI gồm bao nhiêu loại?

Ảo giác AI thường được phân thành 3 dạng phổ biến để dễ phân tích và đánh giá. Tuy vậy, ranh giới giữa các dạng này không hoàn toàn tách biệt. Trong thực tế, một trường hợp ảo giác có thể đồng thời mang nhiều đặc điểm khác nhau. Ví dụ, một câu chuyện do AI tạo ra có thể vừa chứa thông tin sai lệch, vừa xuất hiện các chi tiết bịa đặt hoặc phi logic.

Sai lệch thực tế: Xảy ra khi mô hình AI đưa ra thông tin không đúng với dữ liệu kiểm chứng, chẳng hạn trong các lĩnh vực như lịch sử, khoa học hoặc toán học. Ngay cả những mô hình tiên tiến cũng có thể gặp khó khăn trong việc duy trì độ chính xác ổn định.

Nội dung bịa đặt: Xuất hiện khi mô hình không có đủ thông tin để trả lời nhưng vẫn tạo ra một câu chuyện hư cấu nhằm hoàn thiện phản hồi. Hiện tượng này thường xảy ra ở những chủ đề ít phổ biến hoặc thiếu dữ liệu tham chiếu. Ngoài ra, việc kết hợp nhiều mẫu thông tin riêng lẻ thành một kết luận chính xác cũng là thách thức, khiến mô hình có xu hướng “điền vào chỗ trống” bằng các chi tiết không có thật.

Câu trả lời vô nghĩa: Trong một số trường hợp, AI có thể tạo ra câu trả lời đúng ngữ pháp và mạch lạc về hình thức nhưng thiếu ý nghĩa thực chất. Tình huống này thường xuất hiện khi câu hỏi đầu vào chứa mâu thuẫn hoặc không rõ ràng. Nguyên nhân nằm ở cách mô hình ngôn ngữ hoạt động: chúng dự đoán chuỗi từ dựa trên mẫu dữ liệu đã học thay vì thực sự hiểu nội dung. Vì vậy, kết quả có thể trôi chảy và thuyết phục, nhưng thiếu logic hoặc không truyền tải thông tin hữu ích.

Nguyên nhân nào dẫn đến ảo giác AI?

Ảo giác AI không xuất hiện một cách ngẫu nhiên mà bắt nguồn từ nhiều yếu tố liên quan đến dữ liệu huấn luyện và cơ chế hoạt động của mô hình. Việc hiểu rõ các nguyên nhân cốt lõi sẽ giúp chúng ta đánh giá đúng giới hạn của AI và tìm ra cách giảm thiểu hiện tượng này. Dưới đây là những nguyên nhân chính dẫn đến ảo giác AI.

Thiếu hụt/thiên kiến trong dữ liệu

Một nguyên nhân quan trọng gây ra ảo giác AI là dữ liệu huấn luyện không đầy đủ hoặc chứa thiên kiến. Các mô hình ngôn ngữ lớn phụ thuộc vào dữ liệu để học mẫu và tạo phản hồi, khi dữ liệu thiếu chính xác hoặc không bao quát một chủ đề, mô hình có xu hướng suy đoán và sinh ra thông tin sai.

Vấn đề này thường rõ rệt trong các lĩnh vực chuyên môn cao như khoa học, nơi dữ liệu chất lượng và đa dạng còn hạn chế. Nếu tập huấn luyện nghèo nàn hoặc mô tả mơ hồ, mô hình dễ học thuộc bề mặt thay vì nắm bản chất, dẫn đến hiện tượng học quá khớp và phát sinh ảo giác.

Bên cạnh đó, thiên kiến trong quá trình thu thập hoặc gán nhãn dữ liệu có thể làm sai lệch nhận thức của mô hình. Một tập dữ liệu mất cân bằng, thiên về một góc nhìn nhất định, sẽ khiến AI tái tạo những lệch lạc đó trong câu trả lời.

Kiến trúc mô hình không phù hợp

Ngôn ngữ có cấu trúc phức tạp với nhiều lớp ngữ cảnh và sắc thái biểu đạt, đòi hỏi mô hình AI phải xử lý vượt ngoài các mẫu câu bề mặt. Khi kiến trúc mô hình thiếu độ sâu hoặc năng lực biểu diễn, nó khó nắm bắt đầy đủ ngữ cảnh và dễ tạo ra phản hồi đơn giản hoặc sai lệch.

Hạn chế này khiến mô hình dễ hiểu sai ý nghĩa của từ và cụm từ, từ đó đưa ra diễn giải thiếu chính xác. Vấn đề càng rõ rệt trong các tác vụ chuyên môn cao, nơi yêu cầu khả năng suy luận sâu. Do đó, kiến trúc mô hình chưa phù hợp là một nguyên nhân quan trọng dẫn đến ảo giác AI.

Hiện tượng quá khớp (overfitting)

Học quá khớp (overfitting) khiến mô hình AI khó thích ứng với ngữ cảnh mới và dễ tạo ra phản hồi cứng nhắc hoặc không liên quan. Hiện tượng này xảy ra khi mô hình ghi nhớ chi tiết dữ liệu huấn luyện thay vì học cách khái quát quy luật.

Dù việc học kỹ có thể cải thiện độ chính xác trên dữ liệu cũ nhưng lại gây bất lợi khi mô hình xử lý đầu vào mới, đặc biệt trong môi trường câu lệnh linh hoạt với nhiều cách diễn đạt khác nhau. Khi bị quá khớp, mô hình dễ lặp lại thông tin không phù hợp và vẫn thể hiện sự tự tin sai lệch. Vấn đề này thường rõ rệt trong các lĩnh vực chuyên sâu, nơi dữ liệu huấn luyện chất lượng cao còn hạn chế, làm tăng nguy cơ phát sinh ảo giác AI.

Phương pháp sử dụng để tạo nội dung

Các phương pháp sinh văn bản như tìm kiếm chùm (beam search) và lấy mẫu (sampling) cũng góp phần gây ra ảo giác AI. Những kỹ thuật này được thiết kế để tối ưu độ trôi chảy và tính đa dạng của văn bản, nhưng thường phải đánh đổi bằng độ chính xác.

Tìm kiếm chùm ưu tiên các chuỗi từ có xác suất cao, giúp câu văn mạch lạc nhưng có thể tạo ra nội dung nghe hợp lý mà sai sự thật, đặc biệt trong các tác vụ đòi hỏi độ chính xác cao. Ngược lại, phương pháp lấy mẫu đưa yếu tố ngẫu nhiên vào quá trình sinh văn bản, tăng tính sáng tạo nhưng cũng làm tăng nguy cơ xuất hiện nội dung vô nghĩa hoặc bịa đặt.

Vì vậy, việc cân bằng giữa độ trôi chảy, sáng tạo và độ tin cậy trong AI tạo sinh là một thách thức lớn. Trong các lĩnh vực nhạy cảm như y tế hoặc pháp lý, cần kết hợp thêm cơ chế kiểm chứng thông tin để giảm thiểu rủi ro do ảo giác AI gây ra.

Ảo giác AI mang đến những hệ lụy nào?

Ảo giác AI có thể tạo ra những tác động đáng kể khi các công cụ AI tạo sinh ngày càng được ứng dụng rộng rãi trong doanh nghiệp, học thuật và đời sống. Trong các lĩnh vực rủi ro cao, thông tin sai lệch hoặc bịa đặt từ AI có thể làm suy giảm niềm tin, dẫn đến quyết định sai và kéo theo những hậu quả nghiêm trọng, cụ thể:

- Rủi ro trong ra quyết định: Ảo giác AI có thể gây hậu quả nghiêm trọng khi người dùng tin tưởng vào kết quả mà không kiểm chứng. Trong các lĩnh vực như tài chính, y tế hoặc pháp lý, chỉ một thông tin sai cũng có thể dẫn đến quyết định sai lầm. Ví dụ như chẩn đoán y khoa thiếu chính xác làm chậm điều trị hoặc phân tích tài chính sai gây thiệt hại lớn.

- Thiệt hại kinh tế và uy tín: Các đầu ra sai lệch từ AI có thể khiến doanh nghiệp tốn thêm chi phí để kiểm tra, sửa lỗi và khắc phục hậu quả. Nếu công cụ AI thiếu độ tin cậy được triển khai rộng rãi, doanh nghiệp còn đối mặt với rủi ro mất uy tín, trách nhiệm pháp lý và tổn thất tài chính.

- Lan truyền thông tin sai lệch: Nội dung sai do AI tạo ra nhưng được trình bày thuyết phục có thể lan truyền nhanh, đặc biệt trên mạng xã hội. Điều này làm gia tăng nguy cơ phát tán thông tin sai lệch, ảnh hưởng đến nhận thức cộng đồng và hành vi xã hội, đòi hỏi cả nhà phát triển và người dùng phải có trách nhiệm kiểm soát.

- Xói mòn niềm tin: Khi người dùng liên tục gặp phản hồi sai hoặc gây hiểu nhầm, niềm tin vào hệ thống AI sẽ suy giảm. Thách thức lớn là quản lý kỳ vọng của người dùng, cần minh bạch về giới hạn của AI, đồng thời tăng cường giáo dục để người dùng hiểu rằng kết quả do AI tạo ra luôn cần được kiểm chứng.

Phòng tránh ảo giác AI như thế nào?

Hiện tượng ảo giác AI có thể được hạn chế bằng nhiều biện pháp kết hợp, gồm nâng cao chất lượng dữ liệu huấn luyện, tối ưu và điều chỉnh mô hình, kiểm chứng đầu ra, tăng cường phối hợp giữa con người và AI, cũng như thiết kế câu lệnh đầu vào một cách phù hợp.

Đảm bảo chất lượng dữ liệu huấn luyện

Chất lượng dữ liệu huấn luyện đóng vai trò then chốt trong việc giảm thiểu ảo giác AI. Một tập dữ liệu đa dạng, có tính đại diện và ít thiên kiến giúp mô hình tiếp cận nhiều bối cảnh và sắc thái khác nhau, từ đó tạo ra phản hồi chính xác và đáng tin cậy hơn.

Để đạt được điều này, các đơn vị phát triển cần áp dụng quy trình tuyển chọn dữ liệu chặt chẽ. Chẳng hạn như loại bỏ nguồn kém tin cậy, cập nhật dữ liệu định kỳ và bổ sung nội dung đã được chuyên gia thẩm định. Đồng thời, các kỹ thuật như tăng cường dữ liệu và học chủ động có thể giúp phát hiện khoảng trống thông tin và cải thiện chất lượng tập huấn luyện, trong khi công cụ kiểm soát thiên kiến hỗ trợ duy trì tính cân bằng và đại diện của dữ liệu.

Tinh chỉnh (fine-tuning) mô hình

Tinh chỉnh và hiệu chỉnh mô hình là bước quan trọng để giảm ảo giác AI và nâng cao độ tin cậy của hệ thống. Các quy trình này giúp điều chỉnh hành vi mô hình theo mục tiêu sử dụng, giảm lỗi và tăng mức độ liên quan của đầu ra. Đặc biệt, fine-tuning cho phép tùy biến mô hình tổng quát cho các tác vụ cụ thể, giúp mô hình hoạt động ổn định hơn trong từng ngữ cảnh.

Nhiều phương pháp hỗ trợ quá trình này, tiêu biểu như học tăng cường từ phản hồi con người (RLHF), trong đó mô hình được cải thiện dựa trên đánh giá của người dùng. Bên cạnh đó, điều chỉnh tham số giúp kiểm soát phong cách và mức độ chắc chắn của phản hồi. Các kỹ thuật như dropout, regularization và early stopping cũng được áp dụng để hạn chế quá khớp, giúp mô hình tổng quát hóa tốt hơn thay vì chỉ ghi nhớ dữ liệu.

Xác minh và đối chiếu thông tin

Việc xác minh đầu ra của AI bằng cách đối chiếu với nguồn tin cậy hoặc kiến thức đã được kiểm chứng giúp phát hiện và sửa lỗi kịp thời, từ đó hạn chế rủi ro tiềm ẩn. Cách tiếp cận này đặc biệt quan trọng trong các lĩnh vực yêu cầu độ chính xác cao như giáo dục và nghiên cứu.

Bên cạnh đó, tích hợp bước đánh giá của con người vào quy trình vận hành tạo thêm một lớp giám sát cần thiết. Trong các lĩnh vực rủi ro cao như y tế hoặc pháp lý, cơ chế kiểm duyệt này giúp đảm bảo kết quả từ AI được xem xét cẩn trọng trước khi đưa vào sử dụng.

Tối ưu hóa chất lượng câu lệnh

Từ phía người dùng, cách thiết kế câu lệnh ảnh hưởng trực tiếp đến mức độ xuất hiện của ảo giác AI. Câu lệnh mơ hồ thường dẫn đến phản hồi sai lệch hoặc thiếu liên quan, trong khi yêu cầu rõ ràng và cụ thể giúp mô hình tạo ra kết quả chính xác và hữu ích hơn.

Để tăng độ tin cậy của đầu ra, người dùng nên áp dụng các kỹ thuật thiết kế câu lệnh phù hợp, chẳng hạn chia nhỏ tác vụ phức tạp thành các bước đơn giản và dễ kiểm soát. Cách tiếp cận này giúp giảm độ mơ hồ và hạn chế nguy cơ phát sinh lỗi trong quá trình tạo phản hồi.

Phát triển công nghệ

Các nghiên cứu trong lĩnh vực AI đang tập trung phát triển những mô hình minh bạch và đáng tin cậy hơn để giảm ảo giác AI. Một hướng tiếp cận quan trọng là AI có khả năng giải thích (Explainable AI – XAI), cho phép làm rõ cơ sở hình thành phản hồi, từ đó giúp người dùng đánh giá mức độ tin cậy của kết quả.

Bên cạnh đó, kiến trúc tăng cường truy xuất thông tin (Retrieval-Augmented Generation – RAG) kết hợp mô hình tạo sinh với nguồn dữ liệu bên ngoài để cung cấp câu trả lời dựa trên thông tin đã được xác thực và cập nhật. Cách tiếp cận này giúp giảm nguy cơ bịa đặt và nâng cao độ chính xác của đầu ra.

Ảo giác AI (AI Hallucination) là lời nhắc rằng dù rất mạnh mẽ, trí tuệ nhân tạo vẫn tồn tại những giới hạn và đang tiếp tục được hoàn thiện. Để khai thác hiệu quả tiềm năng của AI và đảm bảo phát triển bền vững, chúng ta cần đẩy mạnh nghiên cứu, cải tiến công nghệ và xây dựng một hệ sinh thái sử dụng AI minh bạch, có trách nhiệm. Hành trình hướng tới những hệ thống AI thực sự đáng tin cậy còn dài, vì vậy con người cần giữ vai trò chủ động trong việc đánh giá và kiểm soát kết quả do AI tạo ra.

Tài liệu tham khảo:

Google Cloud. (n.d.). What are AI hallucinations? https://cloud.google.com/discover/what-are-ai-hallucinations?hl=vi

IBM. (n.d.). AI hallucinations. https://www.ibm.com/think/topics/ai-hallucinations

The Conversation. (n.d.). What are AI hallucinations? Why AIs sometimes make things up. https://theconversation.com/what-are-ai-hallucinations-why-ais-sometimes-make-things-up-242896

The New York Times. (2025, 5 tháng 5). AI hallucinations: ChatGPT, Google. https://www.nytimes.com/2025/05/05/technology/ai-hallucinations-chatgpt-google.html

VnExpress. (2024, 15 tháng 4). Hiện tượng ảo giác dẫn đến AI bịa đặt. https://vnexpress.net/hien-tuong-ao-giac-dan-den-ai-bia-dat-4864534.html