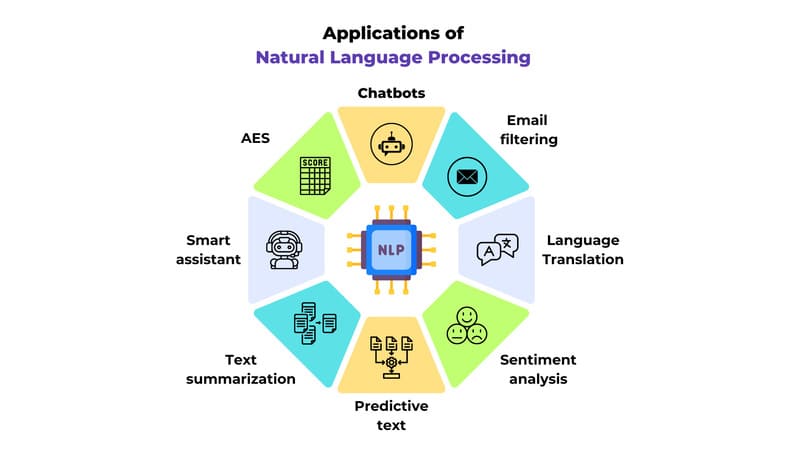

Trong những năm gần đây, xử lý ngôn ngữ tự nhiên (NLP) và thị giác máy tính (Computer Vision) đã phát triển mạnh mẽ, giúp máy móc không chỉ hiểu văn bản mà còn phân tích hình ảnh. Việc kết hợp hai công nghệ này đã tạo ra các mô hình ngôn ngữ thị giác (Vision Language Models – VLMs), cho phép AI xử lý và hiểu đồng thời cả dữ liệu hình ảnh lẫn ngôn ngữ.

Đây cũng chính là nền tảng quan trọng thúc đẩy sự phát triển của các hệ thống AI đa phương thức (multimodal AI), mở ra nhiều ứng dụng đột phá trong chăm sóc khách hàng, giáo dục, y tế, sản xuất và tự động hóa.

Vision Language Model là gì?

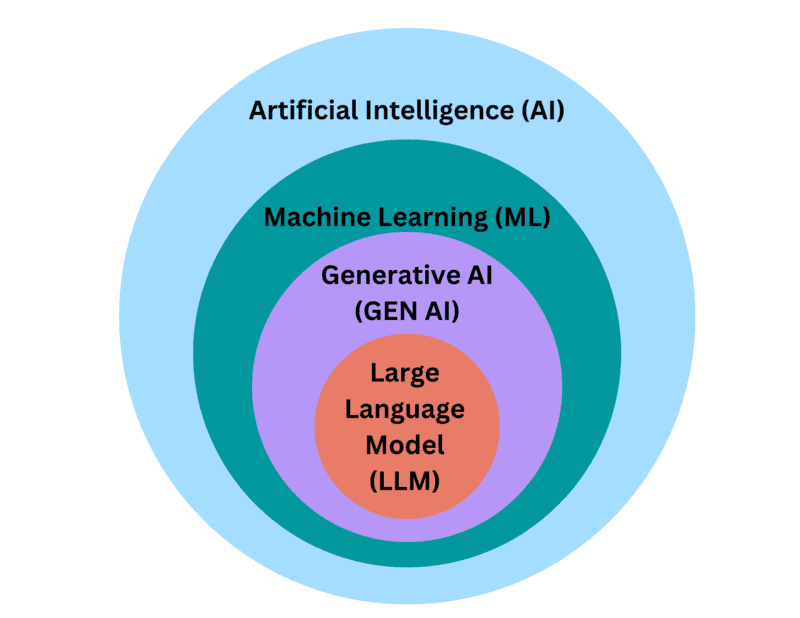

Vision Language Model là hệ thống AI kết hợp giữa mô hình ngôn ngữ lớn (LLM) và bộ mã hóa hình ảnh (vision encoder). Nhờ đó, mô hình không chỉ xử lý văn bản mà còn có khả năng “nhìn thấu” hình ảnh, video và đưa ra phản hồi dựa trên cả hai dạng dữ liệu này.

Thay vì chỉ nhận lệnh văn bản như các LLM truyền thống, VLMs cho phép người dùng đưa dữ liệu đầu vào là hình ảnh, video xen kẽ với câu hỏi hoặc yêu cầu. Mô hình sẽ phân tích nội dung thị giác, hiểu ngữ cảnh và phản hồi bằng văn bản một cách tự nhiên.

VLM quan trọng như thế nào?

Trước đây, các mô hình thị giác máy tính (Computer Vision) truyền thống như Mạng nơ-ron tích chập (CNN – Convolutional Neural Network) thường chỉ giải quyết được những nhiệm vụ cố định, ví dụ như phân loại các loài động vật trong ảnh, hoặc nhận diện ký tự quang học (OCR) mà không hiểu nội dung hình ảnh.

Nhược điểm của những mô hình này là thiếu khả năng mở rộng. Nếu muốn thêm nhiệm vụ mới hay mở rộng tập dữ liệu, cần huấn luyện lại toàn bộ mô hình – tốn thời gian và chi phí.

VLMs khắc phục hoàn toàn điểm yếu đó. Với khả năng “hiểu” ngôn ngữ tự nhiên và xử lý ảnh/video, VLMs có thể:

- Trả lời câu hỏi dựa trên hình ảnh/video (Visual Q&A)

- Phân tích, tóm tắt nội dung hình ảnh/video

- Đọc hiểu tài liệu in tay hoặc viết tay

- Phân tích nhiều ảnh cùng lúc hoặc hiểu video dài

- Linh hoạt thay đổi nhiệm vụ chỉ bằng cách thay prompt (văn bản đầu vào)

VLM hoạt động như thế nào?

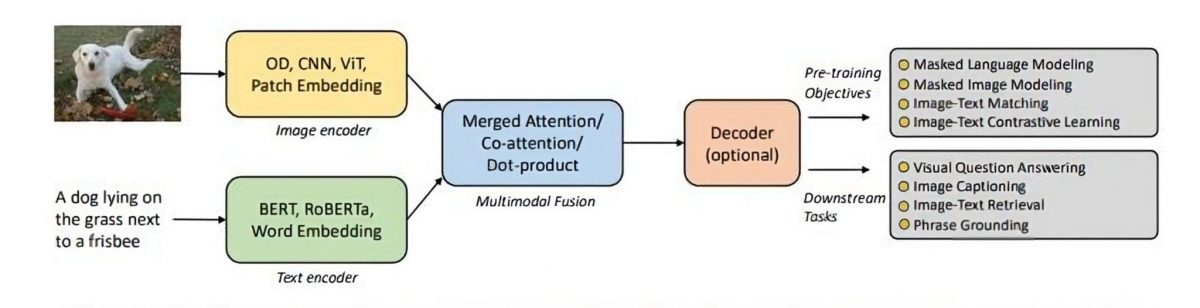

Một mô hình VLM điển hình bao gồm 3 thành phần chính:

- Bộ mã hóa thị giác (Vision Encoder): Thường là mô hình dựa trên CLIP – có khả năng ánh xạ hình ảnh và văn bản vào không gian chung.

- Bộ chuyển đổi (Projector): Lớp trung gian giúp chuyển đổi dữ liệu đầu ra từ Vision Encoder thành dạng mà LLM có thể hiểu (gọi là “image tokens”).

- Mô hình ngôn ngữ lớn – LLM (Large Language Model): Mô hình ngôn ngữ lớn (như LLaMA, GPT…) xử lý prompt đầu vào và sinh phản hồi.

Người dùng tương tác với VLM giống như với một chatbot AI, nhưng có thể chèn thêm hình ảnh vào cuộc hội thoại. VLM sẽ phân tích nội dung thị giác cùng ngữ cảnh hội thoại để đưa ra phản hồi.

Quy trình huấn luyện Vision Language Models

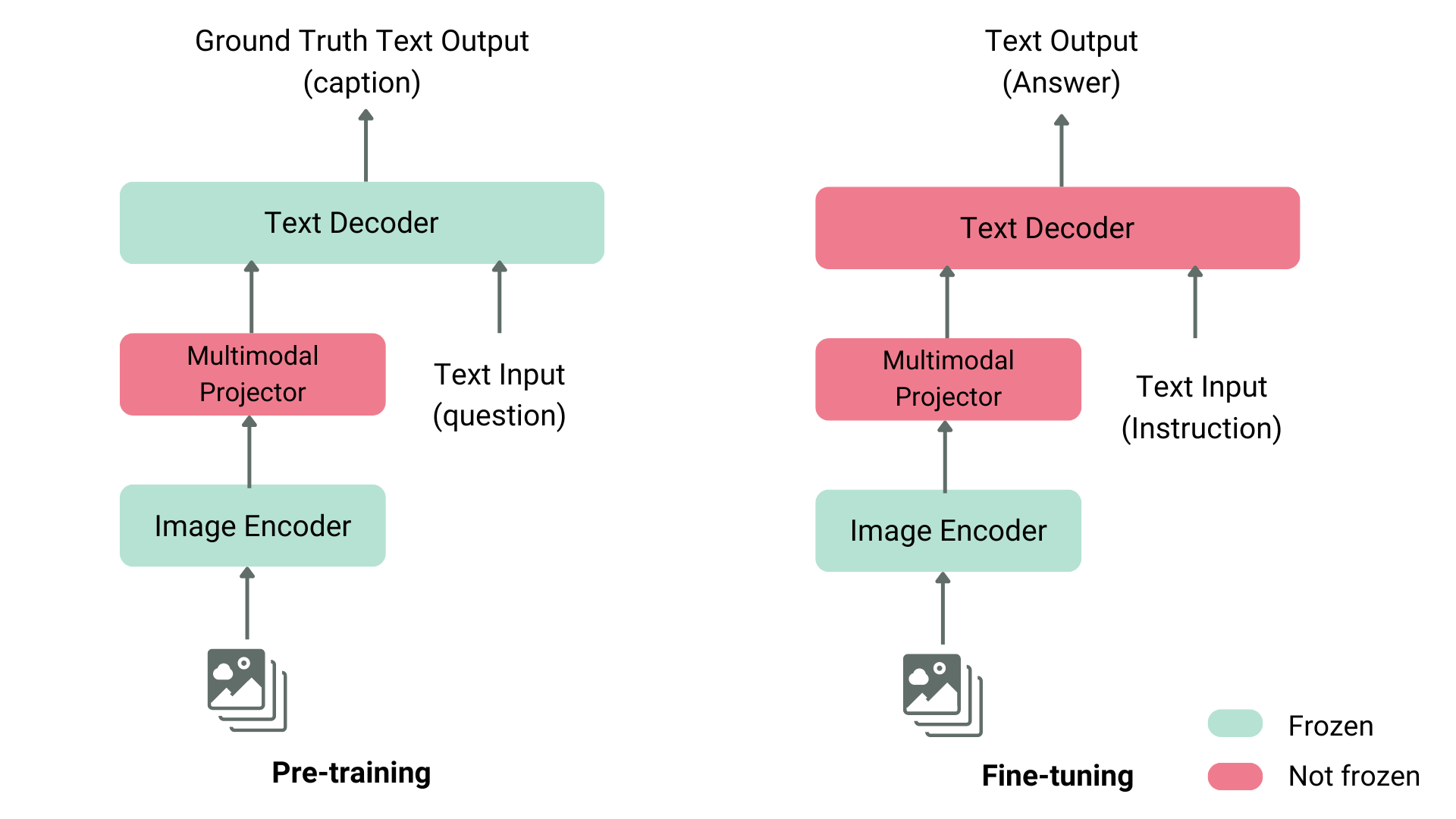

Quá trình huấn luyện VLM bao gồm 3 giai đoạn chính:

- Trước huấn luyện: Huấn luyện trên tập dữ liệu lớn gồm cặp ảnh-văn bản, giúp mô hình đồng bộ hiểu hình ảnh và văn bản.

- Tinh chỉnh có giám sát: Sử dụng các prompt và phản hồi mẫu để huấn luyện mô hình phản hồi đúng theo yêu cầu thực tế.

- Tối ưu hóa hiệu quả tham số – PEFT (Parameter Efficient Fine-Tuning): Tùy chọn cuối giúp tinh chỉnh mô hình nhanh chóng trên dữ liệu riêng biệt của doanh nghiệp.

VLM đang được ứng dụng như thế nào?

Nhờ khả năng xử lý đa phương thức, VLM có thể áp dụng rộng rãi trong nhiều lĩnh vực:

- Bán lẻ: Phân tích hình ảnh camera trong cửa hàng để nhận diện kệ trống, cảnh báo thiếu hàng, hay phân tích hành vi khách hàng.

- Giáo dục: Đọc đề toán viết tay và đưa ra hướng dẫn giải bài chi tiết.

- Doanh nghiệp: Tự động đọc và phân tích tài liệu scan, hóa đơn, báo cáo tay.

- Giao thông: Nhận diện sự cố từ camera giao thông, như tai nạn, cây đổ, xe hư…

- Thể thao: Tạo báo cáo và bình luận tự động từ video trận đấu.

Tại Việt Nam, VLM cũng đã được áp dụng trong nhiều lĩnh vực, trong đó có “nhiệm vụ” giám sát thi công và điều phối giao thông. Cuối năm 2025, Giải pháp nhận diện và phân tích hình ảnh bằng AI đã triển khai thí điểm tại nút giao An Phú và Tân Vạn – hai điểm nóng giao thông của thành phố Hồ Chí Minh. Với sự kết hợp giữa Computer Vision (Object Detection, Object Tracking) và Vision-Language Model (VLM), giúp hệ thống AI “nhìn thấy” và nhận diện các loại đối tượng như phương tiện, máy móc, công nhân, vật cản…. Obejct detection giúp hệ thống trả lời hai câu hỏi: Trong hình ảnh có những gì? Những đối tượng đó đang ở đâu? Từ đó dán nhãn các đối tượng để người dùng dễ dàng theo dõi và quản lý.

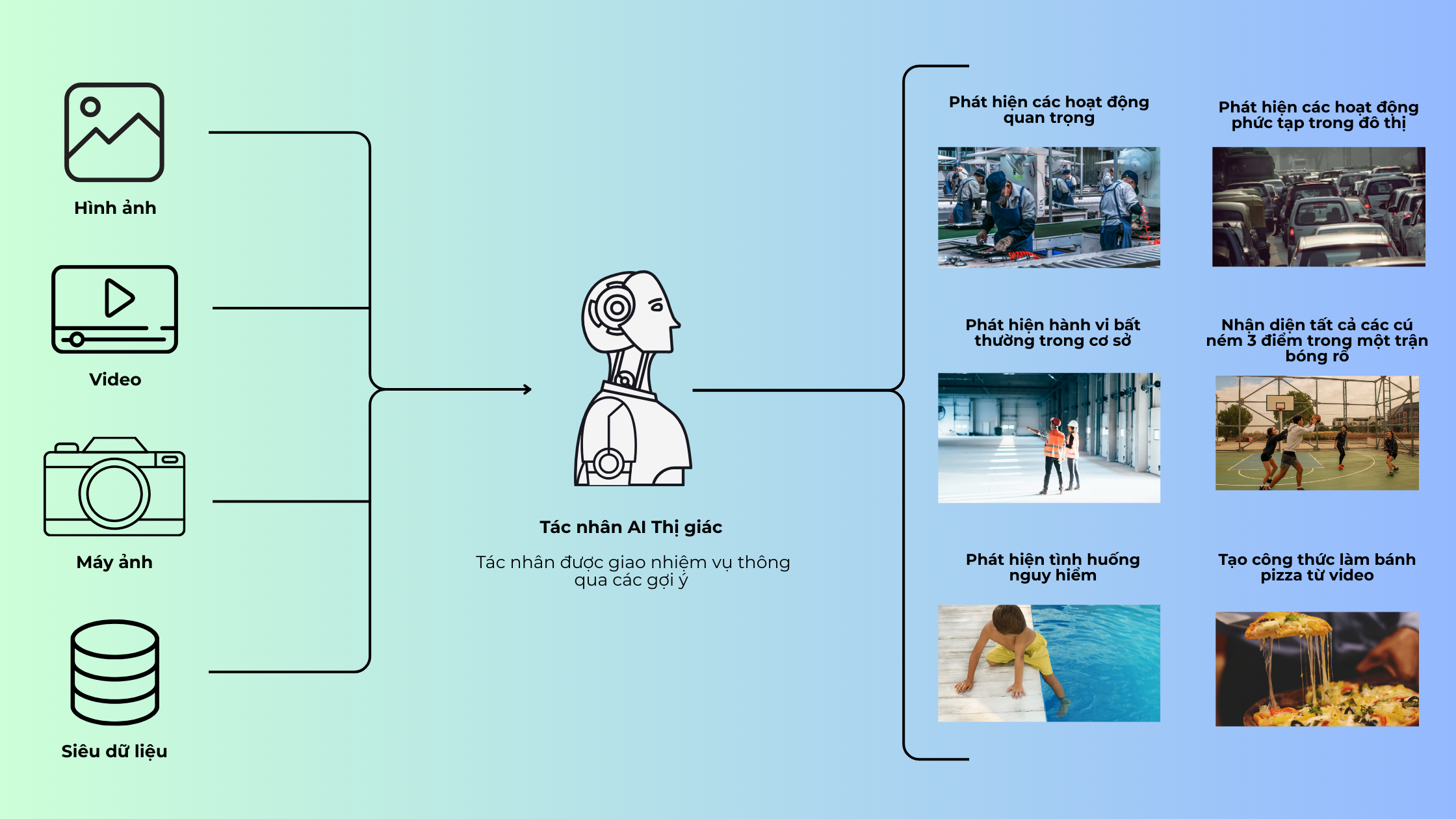

Không chỉ dùng lại ở phương pháp truyền thống trong lĩnh vực Computer Vision, đội ngũ phát triển FPT.AI hiện nay đang sử dụng Mô hình Ngôn ngữ Thị giác (Vision Language Model – VLM), một bước tiến vượt bậc trong việc kết hợp giữa thị giác máy tính và xử lý ngôn ngữ tự nhiên. Khác với các mô hình Computer Vision truyền thống chỉ dừng lại ở việc nhận diện và phân tích hình ảnh, VLM không chỉ hiểu và phân tích hình ảnh mà còn nắm bắt được ngữ cảnh và mối quan hệ sâu sắc giữa hình ảnh và văn bản. Điều này giúp hệ thống AI không chỉ nhận diện sự vật mà còn hiểu rõ bối cảnh diễn ra, từ đó tạo ra các kết luận chính xác và hợp lý hơn. VLM mang lại khả năng hiểu sâu sắc về ngữ cảnh, cho phép dự đoán, giải thích và ra quyết định trong những tình huống phức tạp, mở rộng khả năng ứng dụng trong các lĩnh vực như phân tích đa phương tiện, hỗ trợ ra quyết định thông minh và tự động hóa quy trình công việc.

Kết luận

Vision Language Models là minh chứng rõ ràng cho bước tiến vượt bậc của trí tuệ nhân tạo – nơi AI không chỉ đọc hiểu mà còn nhìn thấy và suy luận. Với tiềm năng ứng dụng rộng khắp, từ phân tích ảnh y tế, giám sát an ninh, sản xuất thông minh đến sáng tạo nội dung, VLMs đang và sẽ tiếp tục tái định hình cách con người và máy móc tương tác với thế giới trực quan.

Trong tương lai gần, VLMs có thể trở thành nền tảng cho các AI Agent thông minh, tự động hóa hàng loạt quy trình cần đến nhận thức thị giác và hiểu biết ngôn ngữ – từ đó mở ra kỷ nguyên mới cho tự động hóa và trải nghiệm người dùng.

Tài liệu tham khảo

Encord. (2024, March 20). Vision-language models (VLMs): A comprehensive guide. Encord Blog. https://encord.com/blog/vision-language-models-guide/

NVIDIA. (n.d.). What are vision-language models (VLMs)? NVIDIA Glossary. https://www.nvidia.com/en-us/glossary/vision-language-models/

Li, L. H., & Hugging Face Team. (2023, July 13). Pretraining vision-and-language models with masked autoencoders. Hugging Face. https://huggingface.co/blog/vision_language_pretraining