Trong bối cảnh trí tuệ nhân tạo ngày càng được ứng dụng rộng rãi, các mô hình ngôn ngữ lớn (LLMs) như ChatGPT hay Google Gemini đã chứng minh vai trò quan trọng trong việc xử lý và tạo ra nội dung. Tuy nhiên, để đáp ứng tốt hơn những yêu cầu phức tạp và cập nhật liên tục, một giải pháp mới đã ra đời: Retrieval-Augmented Generation (RAG).

Vậy Retrieval-Augmented Generation là gì và bằng cách nào mô hình này giúp các trợ lý ảo cải thiện chất lượng phản hồi để đáp ứng nhu cầu đa dạng của người dùng hiện đại? Cùng FPT.AI khám phá nhé!

RAG (Retrieval-Augmented Generation) là gì?

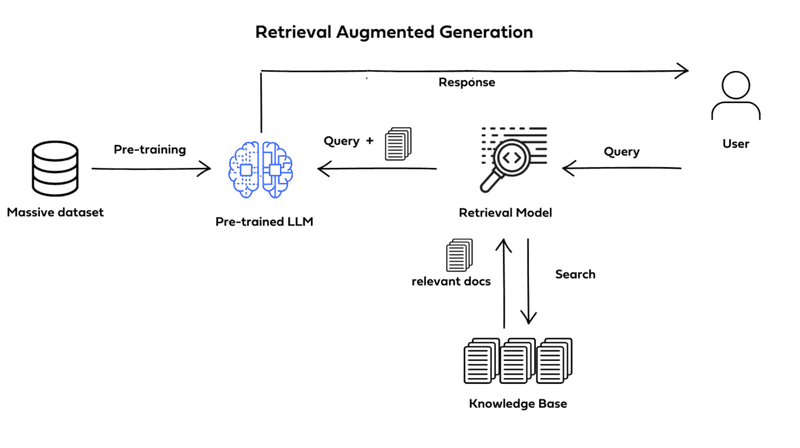

Retrieval-Augmented Generation (RAG) là một mô hình trí tuệ nhân tạo (AI) được phát triển nhằm nâng cao chất lượng phản hồi của các mô hình ngôn ngữ lớn (Large Language Models – LLMs).

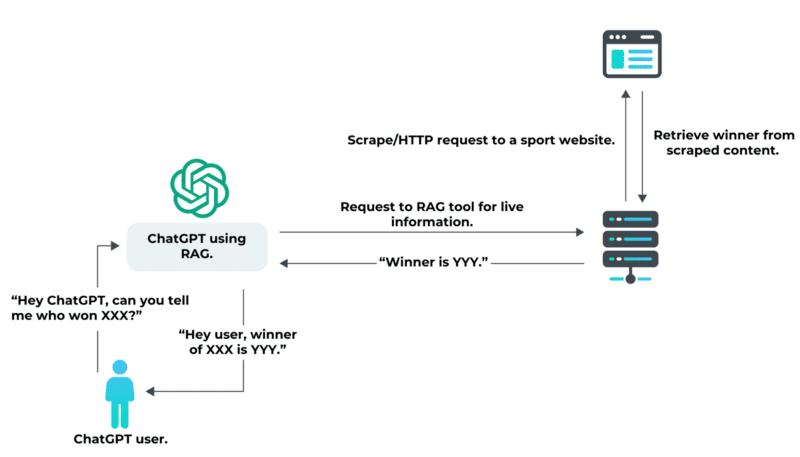

RAG hoạt động bằng cách sử dụng một công cụ truy xuất thông tin (retriever) để lấy dữ liệu từ các nguồn tri thức bên ngoài như: nguồn trực tuyến, application programming interfaces (APIs), cơ sở dữ liệu hoặc kho tài liệu. Sau đó, LLM sẽ tổng hợp và đưa ra câu trả lời hoàn chỉnh. Nhờ đó, nội dung đầu ra vừa đảm bảo tính cập nhật, vừa có căn cứ rõ ràng.

Lịch sử phát triển của RAG

Sự ra đời của RAG (Retrieval-Augmented Generation) gắn liền với quá trình phát triển của hệ thống hỏi đáp và mô hình ngôn ngữ lớn.

Giai đoạn 1970: Hệ thống hỏi đáp và text mining

Từ những năm 1970, các nhà nghiên cứu bắt đầu phát triển hệ thống hỏi đáp (Question Answering Systems) có khả năng truy cập và xử lý văn bản theo chủ đề cụ thể.

Công nghệ lúc này tập trung vào text mining – quá trình phân tích khối lượng lớn dữ liệu phi cấu trúc để trích xuất:

- Khái niệm

- Mẫu dữ liệu

- Chủ đề

- Từ khóa quan trọng

Đây được xem là nền tảng đầu tiên cho các hệ thống AI có khả năng truy xuất thông tin.

Giai đoạn 1990: Hỏi đáp trên công cụ tìm kiếm

Đến những năm 1990, Ask Jeeves (nay là Ask.com) đã phổ biến mô hình hỏi đáp trên nền tảng tìm kiếm. Người dùng có thể nhập câu hỏi tự nhiên thay vì chỉ gõ từ khóa. Điều này mở đường cho các hệ thống truy xuất thông tin thông minh hơn trong tương lai.

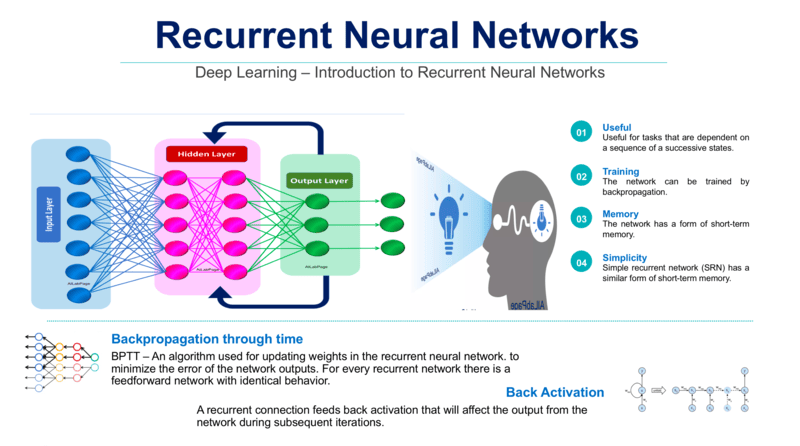

Năm 2017: Bước ngoặt với Transformer

Năm 2017, Google công bố bài nghiên cứu “Attention Is All You Need”, giới thiệu kiến trúc transformer. Kiến trúc này tạo nền tảng cho việc phát triển các mô hình ngôn ngữ lớn (LLMs) có khả năng:

- Hiểu ngữ cảnh tốt hơn

- Mở rộng quy mô huấn luyện

- Tăng hiệu suất xử lý ngôn ngữ tự nhiên

Một năm sau, OpenAI ra mắt mô hình GPT (Generative Pre-trained Transformer), đánh dấu bước tiến quan trọng trong AI tạo sinh.

Năm 2020: RAG chính thức được giới thiệu

Đến năm 2020, RAG được giới thiệu như một framework kết hợp giữa hệ thống truy xuất dữ liệu (retrieval system) và mô hình ngôn ngữ lớn (LLM). Nhóm nghiên cứu tại phòng thí nghiệm AI London của Facebook (nay là Meta) đã tích hợp cơ chế truy xuất vào LLM. Kết quả là mô hình có thể:

- Truy xuất dữ liệu bên ngoài

- Tạo phản hồi có cơ sở thực tế

- Giảm hiện tượng “hallucination” (trả lời không chính xác) của AI

Đây chính là nền tảng hình thành khái niệm Retrieval-Augmented Generation (RAG)

Hiện nay, RAG tiếp tục phát triển và mở rộng ứng dụng. Công nghệ này được triển khai trong nhiều AI chatbot lớn, bao gồm cả ChatGPT.

>>> XEM THÊM: 10 Cách viết prompt ChatGPT hiệu quả cho người mới sử dụng

Cách thức hoạt động của RAG (Retrieval-Augmented Generation Pipeline)

RAG tích hợp một mô hình tạo văn bản (text generator model) với một thành phần truy xuất thông tin (information retrieval component), hoạt động bằng cách tạo chỉ mục (index) cho mỗi đoạn văn trong tài liệu. Khi nhận được một truy vấn (query), RAG sẽ truy xuất những đoạn văn liên quan nhất (thay vì toàn bộ tài liệu) cho các LLMs như ChatGPT, GPT-4,… để tránh tình trạng quá tải thông tin và nâng cao đáng kể chất lượng phản hồi.

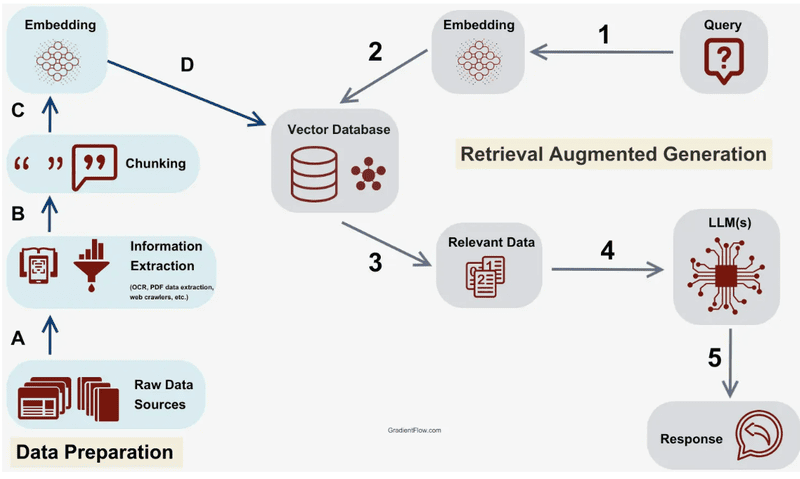

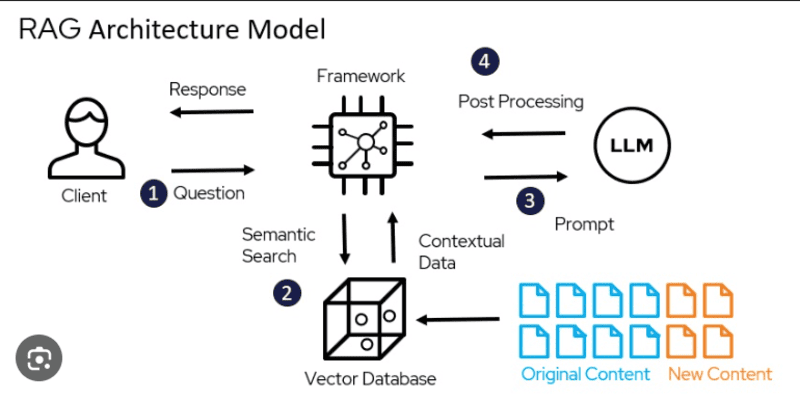

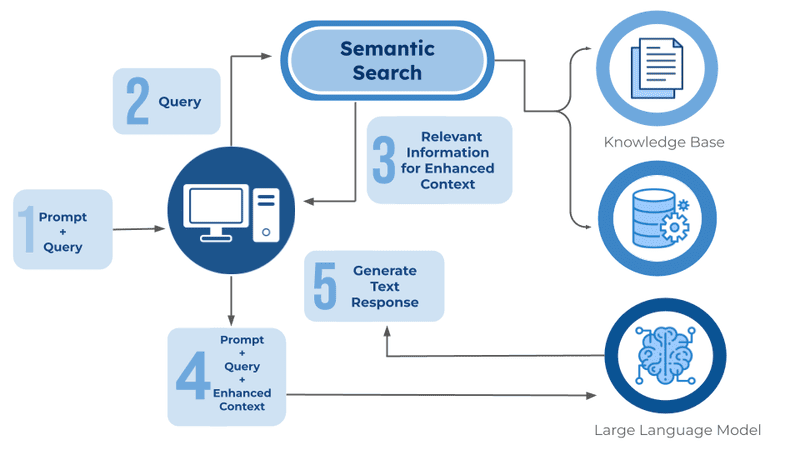

Quy trình hoạt động của RAG gồm các bước:

- Tạo Vector Database: Toàn bộ dữ liệu tri thức được chuyển đổi thành vector embeddings và lưu trữ trong một vector database.

- Nhận truy vấn từ người dùng: Người dùng nhập một truy vấn (query) bằng ngôn ngữ tự nhiên.

- Truy xuất thông tin: Cơ chế retrieval quét qua toàn bộ các vector trong cơ sở dữ liệu để tìm các đoạn văn (paragraphs) có ngữ nghĩa tương đồng với truy vấn của người dùng. Các đoạn văn này sẽ cung cấp thêm ngữ cảnh cho quá trình xử lý.

- Kết hợp dữ liệu: Những đoạn văn được truy xuất sẽ được ghép với câu truy vấn ban đầu để tạo thành một prompt hoàn chỉnh.

- Tạo phản hồi: Prompt được bổ sung ngữ cảnh sẽ được đưa vào LLM để tạo ra phản hồi cuối cùng, phù hợp với ngữ cảnh bổ sung từ các đoạn văn liên quan.

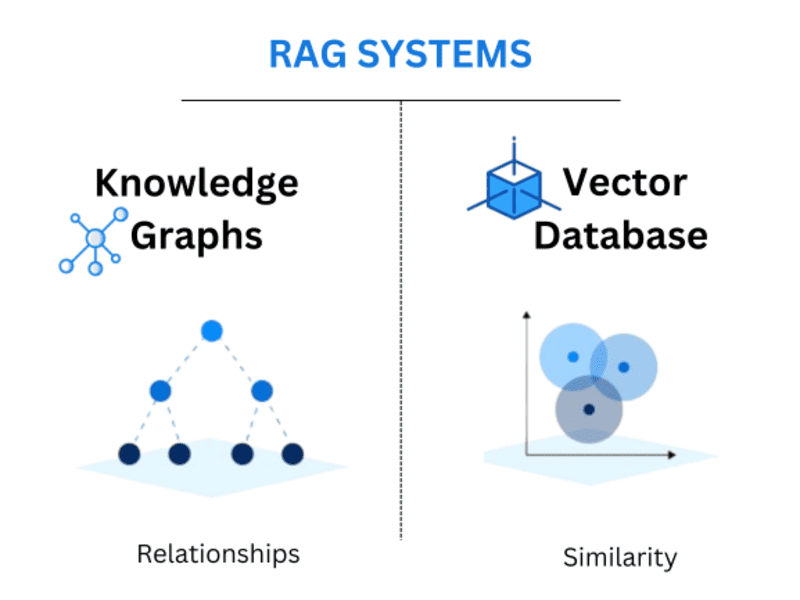

Các công cụ truy xuất (Retriever) trong hệ thống RAG

Trong kiến trúc Retrieval-Augmented Generation (RAG), retriever đóng vai trò quan trọng trong việc tìm kiếm và cung cấp thông tin phù hợp cho mô hình ngôn ngữ. Tùy theo yêu cầu về độ chính xác, mức độ hiểu ngữ nghĩa và loại dữ liệu, doanh nghiệp có thể lựa chọn các công cụ truy xuất khác nhau.

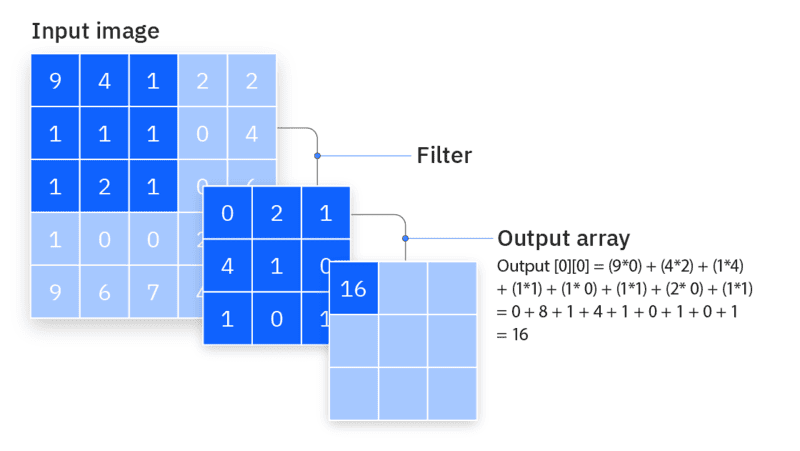

- Vector database: Các truy vấn được chuyển đổi thành vector nhúng (dense vector embedding) thông qua các mô hình như BERT (transformers- based Model). Ngoài ra, các phương pháp truyền thống như TF-IDF có thể được sử dụng để tạo ra sparse embeddings. Việc tìm kiếm dựa trên độ tương đồng ngữ nghĩa (semantic similarity) hoặc tần suất thuật ngữ (term frequency).

- Graph database: Xây dựng cơ sở tri thức (knowledge base) từ các mối quan hệ giữa các thực thể (entity) được trích xuất từ văn bản. Phương pháp này đảm bảo tính chính xác của tri thức nhưng đòi hỏi truy vấn ban đầu phải chính xác, gây khó khăn trong một số trường hợp.

- Regular SQL database: SQL database được sử dụng khi dữ liệu có cấu trúc rõ ràng. Phù hợp với dữ liệu dạng bảng (structured data) với tốc độ truy xuất nhanh và ổn định. Tuy nhiên, SQL database không tối ưu cho xử lý ngữ nghĩa phức tạp, do đó thường không phải lựa chọn chính cho các hệ thống RAG thiên về xử lý ngôn ngữ tự nhiên.

Ứng dụng của RAG đối với doanh nghiệp

RAG giúp doanh nghiệp khai thác hiệu quả dữ liệu sẵn có để tạo ra phản hồi chính xác, cập nhật và phù hợp với từng ngữ cảnh. Dưới đây là các ứng dụng phổ biến của RAG trong từng loại hình doanh nghiệp.

Hệ thống hỏi đáp và chatbot thông minh

RAG giúp chatbot không chỉ phản hồi tự động mà còn có khả năng truy xuất thông tin trực tiếp từ nguồn dữ liệu đáng tin cậy trước khi tạo câu trả lời. Điều này giúp nội dung phản hồi có căn cứ rõ ràng, dễ kiểm chứng và giảm thiểu tình trạng sai lệch hoặc lỗi thời.

Trong chăm sóc khách hàng, RAG chatbot có thể truy xuất chính sách bảo hành, quy trình đổi trả, tình trạng đơn hàng hoặc thông tin lãi suất mới nhất từ hệ thống nội bộ để đưa ra phản hồi chính xác. Trong giáo dục, giải pháp này hỗ trợ tư vấn tuyển sinh dựa trên dữ liệu chương trình đào tạo và quy định cập nhật.

Ví dụ: Ngân hàng có thể triển khai RAG chatbot để trả lời tức thì các câu hỏi về lãi suất hoặc chương trình khuyến mại dựa trên dữ liệu được cập nhật hằng ngày.

Công cụ tìm kiếm thế hệ mới

RAG có khả năng tổng hợp và tóm tắt thông tin từ nhiều nguồn khác nhau, cung cấp câu trả lời cô đọng, rõ ràng thay vì chỉ hiển thị danh sách liên kết. Đây là hướng phát triển quan trọng của công nghệ tìm kiếm hiện đại, được nhiều tổ chức công nghệ lớn đánh giá cao.

Khác với công cụ tìm kiếm truyền thống, hệ thống dựa trên RAG không chỉ truy xuất tài liệu mà còn xử lý và tổng hợp nội dung thành phản hồi hoàn chỉnh. Giúp người dùng tiết kiệm thời gian và nâng cao hiệu quả tiếp cận thông tin.

Phân tích và tra cứu dữ liệu trong doanh nghiệp

RAG hỗ trợ nhân viên tra cứu báo cáo, hợp đồng, tài liệu kỹ thuật hoặc quy định nội bộ một cách nhanh chóng thông qua truy vấn ngôn ngữ tự nhiên. Hệ thống sẽ tự động truy xuất và trích xuất nội dung liên quan từ kho dữ liệu nội bộ trước khi tổng hợp phản hồi. Giải pháp này giúp rút ngắn thời gian tìm kiếm, hạn chế bỏ sót thông tin quan trọng và nâng cao hiệu suất làm việc, đồng thời giảm tải cho bộ phận hỗ trợ nội bộ.

Ví dụ: Trong lĩnh vực sản xuất, kỹ sư bảo trì có thể truy vấn hệ thống để nhận hướng dẫn xử lý một lỗi máy móc cụ thể từ tài liệu kỹ thuật của nhà máy mà không cần tra cứu thủ công.

Ứng dụng trong y tế

Trong lĩnh vực y tế, RAG hỗ trợ bác sĩ truy xuất các nghiên cứu khoa học, hướng dẫn điều trị và hồ sơ bệnh án để đưa ra quyết định chẩn đoán dựa trên căn cứ cập nhật. Hệ thống có thể tổng hợp phác đồ điều trị mới nhất từ cơ sở dữ liệu y khoa quốc tế, giúp rút ngắn thời gian tìm kiếm và tăng độ chính xác trong điều trị.

Ứng dụng trong tài chính và pháp lý

Trong tài chính, RAG hỗ trợ phân tích báo cáo, đối chiếu thông tin thị trường và cung cấp dự báo kịp thời nhằm giảm thiểu rủi ro trong quá trình ra quyết định.

Trong lĩnh vực pháp lý, công nghệ này giúp chuyên gia nhanh chóng tra cứu điều khoản luật, so sánh quy định mới với phiên bản cũ và kiểm tra tính tuân thủ của hợp đồng.

Ví dụ: Công ty chứng khoán có thể ứng dụng RAG để cập nhật liên tục quy định từ cơ quan quản lý và diễn giải nội dung theo ngôn ngữ dễ hiểu cho khách hàng.

Hỗ trợ nghiên cứu và giáo dục

Trong môi trường nghiên cứu và giáo dục, RAG giúp sinh viên, giảng viên và nhà nghiên cứu tiếp cận nhanh chóng nguồn tài liệu học thuật lớn, đồng thời cung cấp bản tóm tắt súc tích, có cấu trúc rõ ràng. Nhờ đó, người dùng tiết kiệm thời gian tìm kiếm và nâng cao hiệu quả nghiên cứu.

Lợi ích và hạn chế khi doanh nghiệp ứng dụng RAG

Lợi ích của RAG

RAG mang lại các lợi ích sau:

- Cung cấp thông tin cập nhật: RAG truy xuất thông tin từ các nguồn có liên quan, đáng tin cậy và được cập nhật mới nhất.

- Tăng cường niềm tin của người dùng: Tùy thuộc vào cách triển khai AI, người dùng có thể truy cập nguồn dữ liệu mà mô hình sử dụng, điều này thúc đẩy tính minh bạch, sự tin tưởng vào nội dung và cho phép người dùng xác minh độ chính xác của thông tin.

- Giảm AI hallucinations: Do LLMs được kết nối với dữ liệu bên ngoài, khả năng mô hình tạo ra hoặc trả về thông tin sai lệch sẽ giảm đáng kể.

- Giảm chi phí tính toán và tài chính: Các tổ chức không cần dành thời gian và nguồn lực để liên tục huấn luyện mô hình với dữ liệu mới.

- Tổng hợp thông tin: RAG kết hợp dữ liệu từ các nguồn truy xuất và mô hình sinh để tạo ra các phản hồi đầy đủ và có liên quan.

- Dễ dàng huấn luyện hơn: RAG không yêu cầu training lại mô hình, tiết kiệm thời gian và tài nguyên tính toán.

- Đa dạng ứng dụng: Ngoài chatbot, RAG có thể được tinh chỉnh để phù hợp với nhiều trường hợp sử dụng cụ thể, chẳng hạn như tóm tắt văn bản và hệ thống hội thoại.

Hạn chế của RAG

Mặc dù có nhiều lợi ích, RAG cũng tồn tại một số thách thức và hạn chế, bao gồm:

- Độ chính xác và chất lượng dữ liệu: Vì RAG truy xuất thông tin từ các nguồn bên ngoài, độ chính xác của phản hồi phụ thuộc vào chất lượng dữ liệu mà nó thu thập. RAG không thể tự đánh giá độ chính xác của dữ liệu mà nó lấy, do đó phản hồi phụ thuộc hoàn toàn vào chất lượng và độ tin cậy của các nguồn dữ liệu.

- Chi phí tính toán: RAG yêu cầu một mô hình và thành phần truy xuất có khả năng tích hợp dữ liệu được truy xuất một cách hiệu quả, dẫn đến việc tiêu tốn nhiều tài nguyên.

- Tính minh bạch: Một số hệ thống có thể không được thiết kế để cho người dùng biết nguồn gốc của dữ liệu, điều này có thể ảnh hưởng đến sự tin tưởng của người dùng.

- Độ trễ (Latency): Việc thêm bước truy xuất vào LLM có thể làm tăng độ trễ trong phản hồi, đặc biệt nếu cơ chế truy xuất cần tìm kiếm qua các cơ sở tri thức lớn.

Sự khác biệt giữa RAG và Fine-tuning là gì?

Khi tìm hiểu RAG là gì, nhiều doanh nghiệp thường so sánh phương pháp này với Fine-tuning – kỹ thuật tinh chỉnh mô hình ngôn ngữ lớn (LLM). Mặc dù đều hướng tới mục tiêu nâng cao chất lượng phản hồi, hai phương pháp có cơ chế hoạt động và phạm vi ứng dụng hoàn toàn khác nhau.

| Tiêu chí | RAG (Retrieval-Augmented Generation) | Fine-tuning (Tinh chỉnh mô hình) |

| Cách tiếp cận | Truy xuất dữ liệu từ các nguồn bên ngoài như cơ sở dữ liệu, tài liệu nội bộ hoặc kho tri thức, sau đó cung cấp ngữ cảnh cho LLM để tạo phản hồi | Huấn luyện bổ sung LLM trên tập dữ liệu chuyên biệt nhằm điều chỉnh hành vi và nâng cao chuyên môn của mô hình |

| Cập nhật tri thức | Có thể cập nhật nhanh chóng bằng cách bổ sung hoặc điều chỉnh dữ liệu trong hệ thống truy xuất | Cần thực hiện huấn luyện lại mô hình khi xuất hiện dữ liệu mới |

| Chi phí triển khai | Tối ưu chi phí do không yêu cầu tái huấn luyện toàn bộ mô hình | Yêu cầu tài nguyên tính toán cao và thời gian huấn luyện đáng kể |

| Khả năng mở rộng | Linh hoạt, dễ tích hợp nhiều nguồn dữ liệu khác nhau | Bị giới hạn bởi tập dữ liệu đã sử dụng trong quá trình huấn luyện |

| Tính chính xác và minh bạch | Phản hồi có căn cứ, có thể truy vết và dẫn nguồn thông tin | Nội dung phụ thuộc vào dữ liệu huấn luyện, khó xác định nguồn gốc cụ thể |

Nên sử dụng Retrieval-Augmented Generation (RAG) hay Semantic Search?

RAG (Retrieval-Augmented Generation) và Semantic Search đều được ứng dụng trong các hệ thống AI hiện đại nhằm nâng cao độ chính xác xử lý thông tin. Tuy nhiên, hai phương pháp này có mục tiêu và cách tiếp cận khác nhau, dẫn đến sự khác biệt rõ rệt trong ứng dụng thực tế.

| Tiêu chí | Retrieval-Augmented Generation (RAG) | Semantic Search |

| Khái niệm | Kiến trúc kết hợp truy xuất dữ liệu bên ngoài với mô hình ngôn ngữ lớn (LLM) để tạo phản hồi có căn cứ | Kỹ thuật tìm kiếm tập trung vào việc hiểu ý định và ngữ nghĩa của truy vấn |

| Mục tiêu chính | Cải thiện chất lượng phản hồi của LLM bằng cách bổ sung ngữ cảnh từ nguồn dữ liệu cập nhật | Nâng cao độ chính xác tìm kiếm thông qua hiểu ngữ cảnh và ý định người dùng |

| Công nghệ nền tảng | LLM, Vector Database, Embeddings, NLP | NLP, Machine Learning (ML), phân tích hành vi người dùng |

| Cách xử lý truy vấn | Truy xuất các đoạn nội dung liên quan từ cơ sở dữ liệu, sau đó đưa vào LLM để tổng hợp phản hồi | Phân tích thuật ngữ, ngữ cảnh, lịch sử tìm kiếm và vị trí địa lý để trả về kết quả phù hợp |

| Khả năng cập nhật thông tin | Có thể truy xuất dữ liệu mới theo thời gian thực | Phụ thuộc vào dữ liệu đã được lập chỉ mục trong hệ thống tìm kiếm |

| Ứng dụng phổ biến | Chatbot doanh nghiệp, hệ thống Q&A, tra cứu tài liệu nội bộ, AI trợ lý chuyên môn | Công cụ tìm kiếm web, thương mại điện tử, CMS, chatbot hỗ trợ tìm kiếm |

| Điểm mạnh nổi bật | Giảm AI hallucination, phản hồi có căn cứ và minh bạch | Hiểu sâu ý định người dùng, cải thiện trải nghiệm tìm kiếm |

| Hạn chế | Cần hạ tầng truy xuất và quản lý dữ liệu | Không tự tạo nội dung mới, chỉ trả về kết quả tìm kiếm |

| Trường hợp sử dụng phù hợp | Khi cần thông tin cập nhật, tổng hợp và giải thích chi tiết | Khi cần tối ưu độ chính xác tìm kiếm dựa trên ý định người dùng |

| Khả năng kết hợp | Có thể sử dụng semantic search để nâng cao chất lượng truy xuất trong pipeline RAG | Có thể hoạt động độc lập hoặc tích hợp trong hệ thống RAG |

RAG và Semantic Search không thay thế nhau mà có thể bổ trợ lẫn nhau trong kiến trúc AI hiện đại. Semantic Search giúp cải thiện chất lượng truy vấn và độ chính xác tìm kiếm, trong khi RAG nâng cao khả năng tạo phản hồi của LLM bằng cách bổ sung ngữ cảnh từ nguồn dữ liệu bên ngoài.

Nên sử dụng Graph database hay Vector database trong RAG?

So với Vector database, Graph database thường được ưu tiên trong RAG vì khả năng lưu trữ tri thức với độ chính xác cao.

Vector database chia nhỏ và lập chỉ mục (indexing) dữ liệu bằng cách sử dụng vector được mã hóa bởi LLM để truy xuất thông tin dựa trên ngữ nghĩa. Tuy nhiên, phương pháp này có thể dẫn đến việc lấy phải những thông tin không liên quan, gây sai lệch kết quả. Trong khi đó, Graph database tập trung vào việc xây dựng cơ sở tri thức từ các mối quan hệ rõ ràng giữa các thực thể, làm cho quá trình truy xuất thông tin trở nên ngắn gọn và chính xác hơn.

Dù vậy, Graph database yêu cầu các truy vấn phải phù hợp và chính xác với cách dữ liệu được lưu trữ và liên kết. Điều này có nghĩa là nếu người dùng không nắm rõ cấu trúc và cách liên kết thông tin, việc truy xuất thông tin mong muốn có thể trở nên khó khăn.

Tổng kết

Tóm lại, Retrieval-Augmented Generation (RAG) đã chứng minh tiềm năng to lớn trong việc cải thiện khả năng của các mô hình ngôn ngữ lớn (LLMs) nhờ vào việc kết hợp dữ liệu bên ngoài với các thuật toán hiện đại. Không chỉ giải quyết được những hạn chế như AI hallucination hay khoảng trống kiến thức, RAG còn mở ra những ứng dụng mới trong nhiều lĩnh vực, từ trợ lý ảo, chatbot đến hệ thống hỏi đáp thông minh. Hy vọng bài viết trên của FPT.AI đã mang đến cho bạn các thông tin bổ ích.

Nếu cần tư vấn chuyên sâu hơn về hệ sinh thái FPT GenAI, hãy liên hệ với chúng tôi. Đây là nền tảng Generative AI (AI tạo sinh) tiên tiến, tập trung vào 5 yếu tố chính

- Hoạt động mạnh mẽ: FPT GenAI được thiết kế với khả năng xử lý dữ liệu nhanh chóng, đạt tốc độ lên đến 12,000 tokens/giây. Độ dài ngữ cảnh tối đa 128,000 tokens giúp nền tảng hiểu sâu hơn các tình huống phức tạp, đồng thời tích hợp 8 tỷ tham số để xử lý các bộ dữ liệu lớn và đa dạng, đảm bảo hiệu suất hoạt động tối ưu.

- Đa ngôn ngữ: Nền tảng hỗ trợ tương tác bằng nhiều ngôn ngữ, bao gồm tiếng Việt, tiếng Anh, và tiếng Indonesia, tạo điều kiện cho các doanh nghiệp mở rộng quy mô hoạt động trên thị trường quốc tế, đáp ứng nhu cầu giao tiếp đa văn hóa và đa ngôn ngữ một cách linh hoạt và tự nhiên.

- Tích hợp với chatbot trên các nền tảng nhắn tin: FPT GenAI hỗ trợ nhiều dạng tương tác phong phú, từ nội dung văn bản, hình ảnh đến định dạng Carousel, giúp các doanh nghiệp triển khai các giải pháp chăm sóc khách hàng, tư vấn trực tuyến hoặc hỗ trợ nhóm chat một cách hiệu quả và tối ưu hóa trải nghiệm hội thoại.

- Tạo sinh từ nguồn kiểm chứng được (RAG): Với công nghệ RAG, FPT GenAI khai thác tri thức từ các nguồn dữ liệu nội bộ và đáng tin cậy của doanh nghiệp. Nền tảng này có khả năng tùy chỉnh theo đặc thù ngành nghề, đảm bảo phản hồi chính xác, cập nhật và chất lượng cao, mang lại lợi ích thực tiễn trong quá trình vận hành.

- Mô hình ngôn ngữ tùy chỉnh: FPT GenAI được thiết kế để đáp ứng nhu cầu đặc thù của từng doanh nghiệp. Các kỹ thuật hiện đại như zero-shot và few-shot giúp giảm thời gian đưa sản phẩm ra thị trường, đồng thời hỗ trợ phát triển nhanh chóng các giải pháp độc đáo, đáp ứng yêu cầu kinh doanh cụ thể với hiệu quả cao.

Khám phá ngay FPT GenAI để trải nghiệm những đột phá mà công nghệ RAG và AI tạo sinh mang lại cho doanh nghiệp bạn.

Nguồn tham khảo:

- (n.d.). Retrieval-Augmented Generation là gì?. Truy cập ngày 18 tháng 1 năm 2025, từ https://www.techtarget.com/searchenterpriseai/definition/retrieval-augmented-generation

- (n.d.). ChatGPT Series #5: Tìm hiểu về Retrieval-Augmented Generation (RAG). Truy cập ngày 18 tháng 1 năm 2025, từ https://viblo.asia/p/chatgpt-series-5-tim-hieu-ve-retrieval-augmented-generation-rag-Ny0VGRd7LPA

>>> XEM THÊM: